8月22日,腾讯云上线DeepSeek-V3.1版本,企业和开发者可以通过腾讯云直接调用新版模型的API接口,获得稳定优质的服务。同时,腾讯云智能体开发平台(ADP)也接入了新版模型,通过平台内置的RAG、工作流和智能体开发的能力,用户可以快速搭建专属智能体应用。新模型在腾讯云TI平台上也第一时间上架,用户可以基于TI平台,快速部署专属DeepSeek-V3.1服务。

用户可以登陆腾讯云官网调用新模型的接口:https://cloud.tencent.com/document/product/1772/115969

也可以基于腾讯云智能体开发平台内置的DeepSeek-V3.1新模型快速搭建智能体。

腾讯云智能体开发平台内置行业实践流程、领先的 RAG 算法,只需导入文档/问答对,即可让智能体对接企业多模态知识,达到稳定精确的知识问答效果。支持画布式灵活编排工作流,可快速将企业系统 API 接入智能体,智能体输出更稳定可控。同时,提供 LLM+RAG 、Multi-agent、Workflow 等多种智能体开发框架,支持应用配置-应用调试-应用评测-应用发布一站式工具链,助力企业降低智能体构建门槛。

腾讯云智能体开发平台ADP

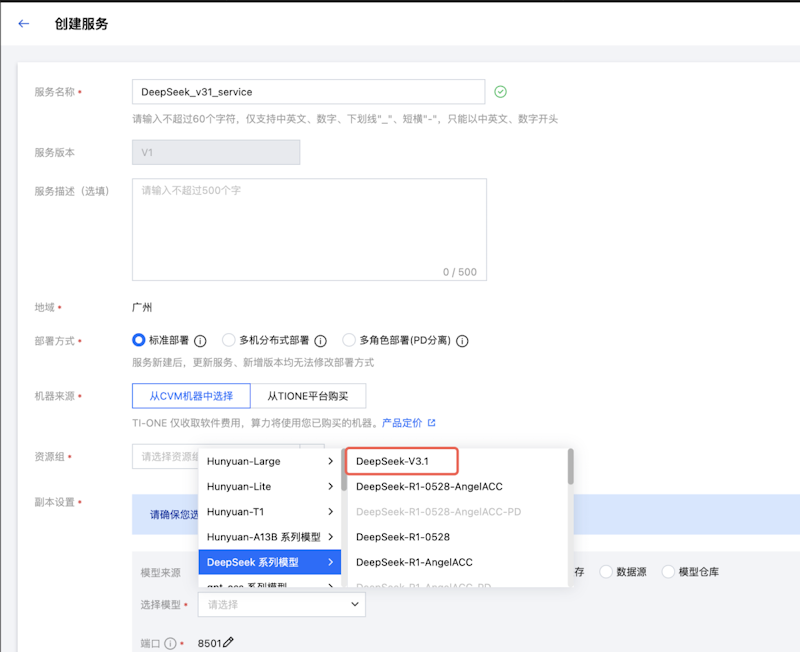

此外,DeepSeek新版模型在腾讯云TI平台上也第一时间上架,用户可一键部署DeepSeek-V3.1专属服务,满足企业的个性化需求。TI平台在业内率先支持DeepSeek全系模型的企业级精调与推理全链路功能,为金融、医疗、制造、零售等多个行业提供了更高效、便捷的AI模型构建及应用方案,进一步降低企业在大模型应用中的技术门槛和研发成本。

腾讯云TI平台

DeepSeek-V3.1在工具调用和智能体支持上进一步增强,思考效率也进一步提升,具体体现在:

混合推理架构:一个模型同时支持思考模式与非思考模式;

更高的思考效率:相比 DeepSeek-R1-0528,DeepSeek-V3.1-Think 能在更短时间内给出答案。其测试结果显示,经过思维链压缩训练后,V3.1-Think 在输出 token数减少20%-50%的情况下,各项任务的平均表现与R1-0528持平;同时,V3.1 在非思考模式下的输出长度也得到了有效控制,相比于 DeepSeek-V3-0324 ,能够在输出长度明显减少的情况下保持相同的模型性能。

更强的 Agent 能力:通过 Post-Training 优化,新模型在工具使用与智能体任务中的表现有较大提升。比如,在编程智能体上,在代码修复测评 SWE 与命令行终端环境下的复杂任务(Terminal-Bench)测试中,DeepSeek-V3.1 相比之前的 DeepSeek 系列模型有明显提高。

腾讯云是国内率先支持DeepSeek API+联网搜索的云厂商。为了提供更优质的DeepSeek模型服务,腾讯云在推理加速层面不断优化,通过深挖内核和架构延展,以及PD分离、NIXL传输技术,在精度几乎无损的前提下,实现服务时延的大幅降低,以及吞吐能力的大幅提升。比如用户使用DeepSeek R1,在3.5K输入、1K输出的典型场景下, 保障首Token延时不高于2秒,吐字速率不低于每秒15Tokens的同时,2机16卡的QPM超过200;使用DeepSeek V3-0324,在3.5K输入、0.67K输出的典型场景下,2机16卡的QPM达到260。

通过持续的技术优化和产品打磨,腾讯云DeepSeek API以及智能体开发平台、TI平台已经服务了众多客户,覆盖互联网、金融、零售、政务、出行等众多领域。

「免责声明」:以上页面展示信息由第三方发布,目的在于传播更多信息,与本网站立场无关。我们不保证该信息(包括但不限于文字、数据及图表)全部或者部分内容的准确性、真实性、完整性、有效性、及时性、原创性等。相关信息并未经过本网站证实,不对您构成任何投资建议,据此操作,风险自担,以上网页呈现的图片均为自发上传,如发生图片侵权行为与我们无关,如有请直接微信联系g1002718958。